![图片[1]-音频生成技术探索与淘宝域实践 - AI资源导航站-AI资源导航站](https://www.aitube.vip/wp-content/uploads/2025/03/20250331_67ea97f576732.gif)

作为一种新的商品表现形态,内容几乎存在于手淘用户动线全流程,例如信息流种草内容、搜索消费决策内容、详情页种草内容等。过去一年,我们通过在视频生成、图文联合生成等核心技术上的持续攻关,AIGC内容生成在手淘多个场景取得了规模化落地价值。本专题《淘宝的AIGC内容生成技术总结》是我们摸索出的一部分实践经验,我们将开启一段时间的内容AI专题连载,欢迎大家一起交流进步。

第三篇《OpenAI o1模型的前世今生》

第四篇《多模态人物视频驱动技术回顾与业务应用》

背景

24年国庆期间音频生成技术的二次爆发,AI语音席卷社交平台,为大家带来了欢乐也引发了新的担忧。在2023年AI歌手爆火后,是什么样的新技术再次引发了AI音频生成的热潮?

23年爆火的AI歌手多使用 so-vits-svc 歌声转换项目制作。该模型可以转换原始歌曲中歌唱者的声色,而不改变歌声的韵律、节奏等,达到改变歌曲演唱者的效果。简单来说,歌声转换就是歌声版的柯南变声器。

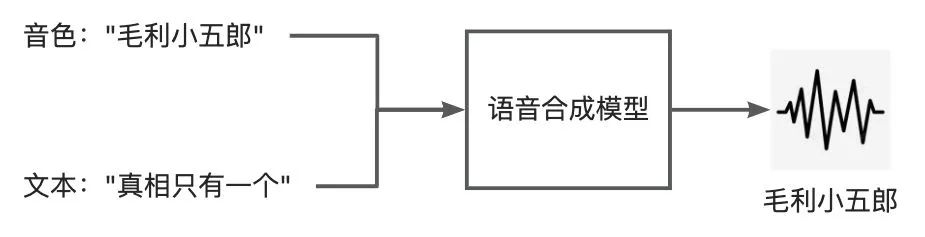

而24年下半年各个短视频平台涌现的AI名人语音则多使用语音合成方法。语音合成又被称为文语转换(Text-to-Speech, TTS),与歌声转换同属于AI音频生成技术。如图2所示,语音合成与歌声转换在输入层面较为不同。语音合成的目标是将按照用户指定的文本和音色合成语音。

图2: 语音合成

相较以往语音合成的特别之处?

-

成本显著降低:新一代语音合成模型仅需3s语音就可以复刻任何人的音色,使得普通用户进行个性化的创作成为可能。 -

表现力提升:在复刻音色的同时,能够模仿目标说话者真实、自然的韵律,甚至情感表达

下面是笔者自己声音的简单展示,可以看到模型能够在只有 3s 语音的情况下复刻笔者的音色进行合成。

输入

我来自淘天集团,你想听我介绍语音大模型嘛?

合成语音

技术原理

▐ 风格迁移

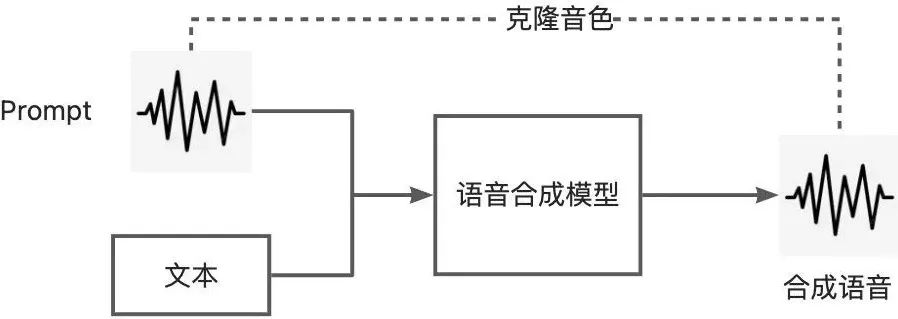

在支持多个音色的语音合成中,用户通常需要以标签或是参考音频的形式选择他们所需要的特定音色。如图3中,当用户为语音合成模型提供一条参考音频(prompt)时,语音合成模型将复刻该参考音频中的音色进行合成。

过去,个性化的数据收集以及模型的微调流程是普通用户实现“音色复刻”的拦路虎。

在以往的方法中,语音合成模型的泛化能力不足导致参考音频并不能由用户任意选择。当用户选择没有在训练数据中出现过的音色作为prompt时,合成效果会出现显著的下降。如果用户希望对可用音色库进行扩展,需要先收集目标角色数十分钟的语音,然后对模型进行微调训练。

此外,收集的数据质量对于最终合成语音的效果有着决定性的影响,优质的训练数据对于模型的效果至关重要。在理想的状况下,这些数据应该由目标说话者在专业录音室中录制。一些相对容易收集的网络语音数据,由于带有BGM、环境噪声、多人对话等干扰,需要经过复杂的清洗流程或是精细的人工筛选才能达到较好的效果。这样的流程对于普通用户来说是难以实现的。

▐ 语音大模型

-

VALL-E

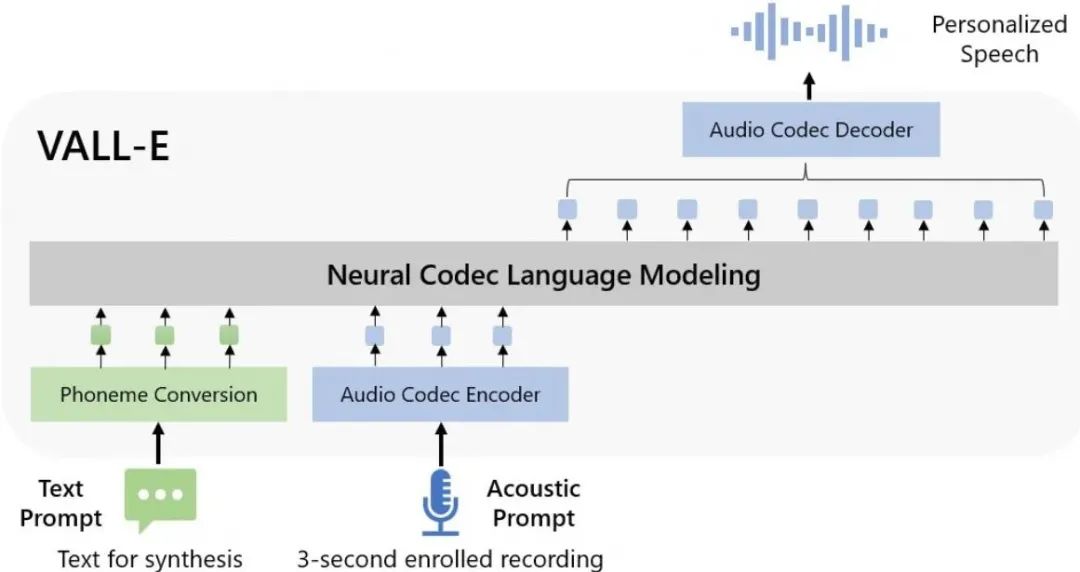

为了解决上述语音合成模型泛化性的问题,2023 年初微软的 VALL-E 借鉴 GPT 等语言模型在 In-context learning (ICL) 上的成功经验,实现了对任意 3 秒钟参考音频的支持,开始了属于语音合成的“大模型”时代:

-

LLM :如图4,VALL-E 改变 TTS 常见的 Encoder-Decoder 架构,首次使用语言模型作为生成网络 -

音频表征:为了适配 LLM,使用 Residual Vector Quantization (RVQ) 结构的 Codec 作为 tokenizer 将语音离散化,而不再使用连续表征梅尔频谱 -

数据量x100 :语音合成模型训练所需数据量一般小于600小时,VALL-E 使用了6万小时的英文数据训练

VALL-E 通过数据和模型上的 scale up 实现了显著的泛化能力提升。VALL-E 在只有3秒钟集外 prompt 的情况下,合成效果甚至超越此前的 SOTA 方法在集内 prompt 下的合成效果。但是, VALL-E 使用的 Codec tokenizer 原本是用于音频压缩任务的方法,导致其在合成音质和推理速度上的表现差强人意。

-

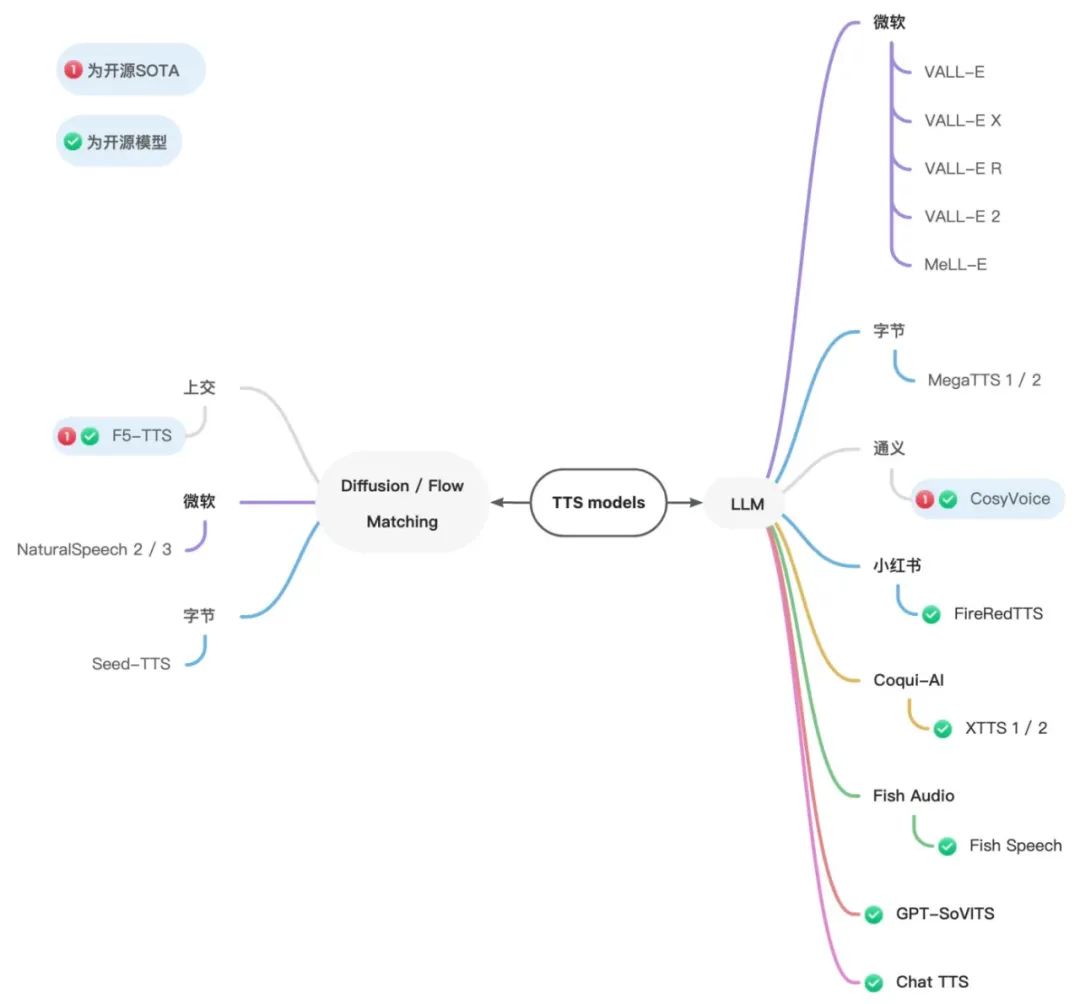

SOTA

在 VALL-E 之后的一年中,涌现了许多优秀的语音大模型工作。笔者在此仅按照生成模型作简单的分类列举。

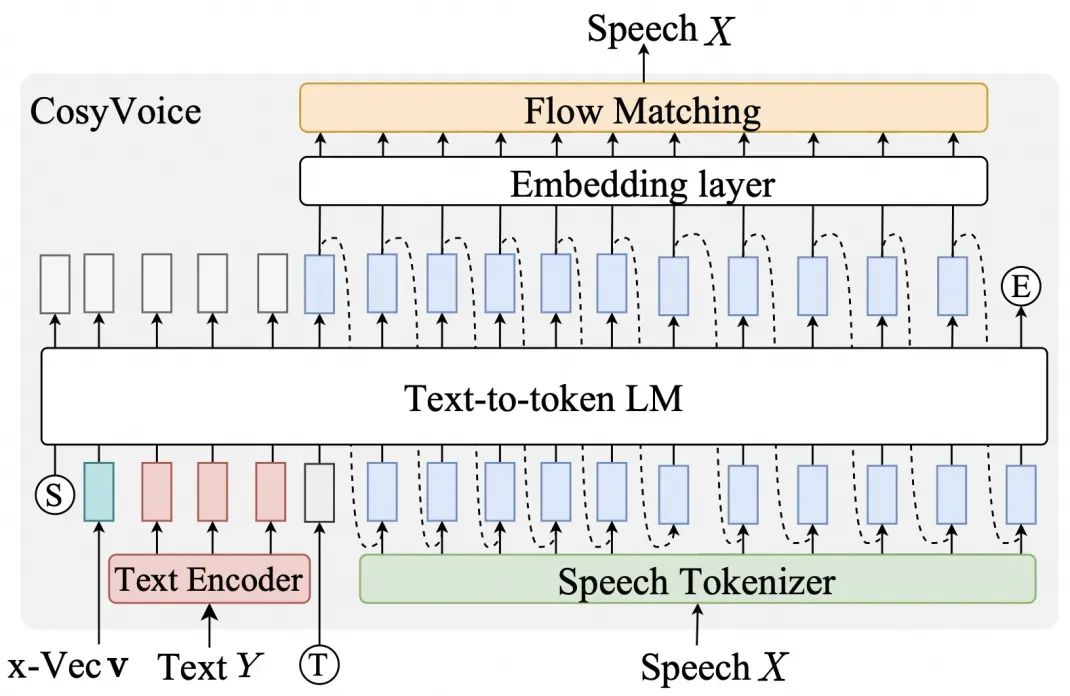

其中,通义开源的 CosyVoice 是较为优秀、成熟且稳定的开源方案,目前网络上的音色复刻项目也多基于该技术实现。该模型也遵循了图3中基于参考音频的语音合成的范式,输入音色prompt和文本合成语音。

图6:CosyVoice 模型结构

图6:CosyVoice 模型结构

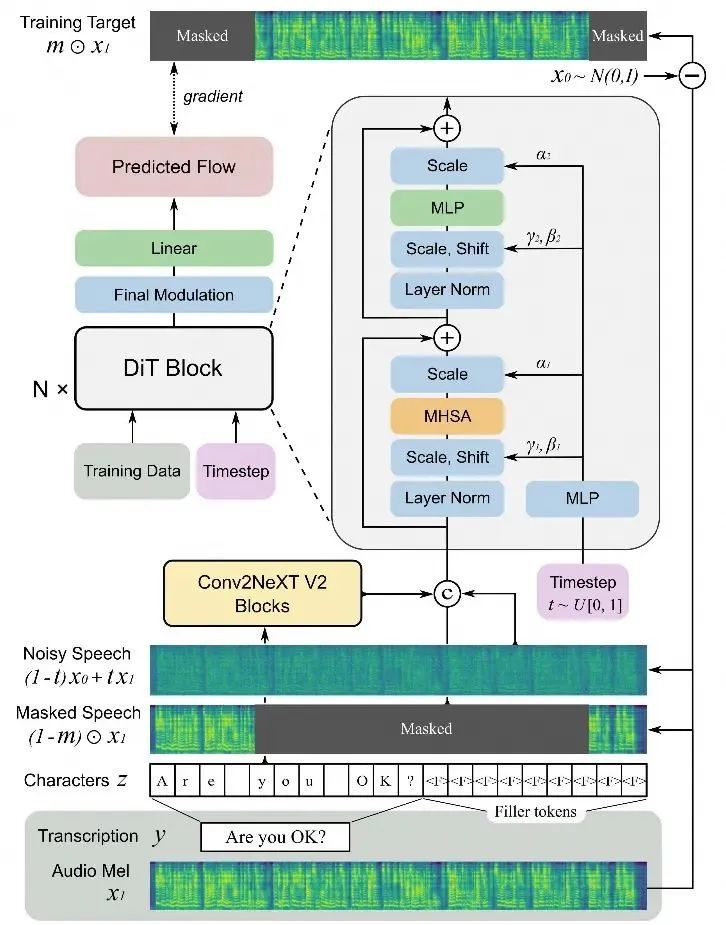

之后,上海交通大学发表的 F5-TTS 使用图7中的 DIT 结构,采用语音填充任务进行训练。在推理速度、读音准确度 等指标上实现对CosyVoice的超越。

-

语音大模型 vs 语言大模型

尽管都被称作大模型,语音大模型在参数量以及数据规模上相较语言大模型仍有相当的差距。

-

模型大小:语音合成大模型 CosyVoice 参数量为 300M, 相较此前 30~50M 的语音合成模型已有较大提升,但是距离语言模型2B以上的参数量仍有不小的差距。 -

Pre-train数据规模:目前的论文中,语音大模型涉及到的训练数据大多在5~20万小时。100万小时的语音数据大约能够包含60亿文字token,而语言大模型 LLaMA 3 在 pre-train 中使用的 token 数约为该数字的250倍。

淘宝域实践

▐ 数据挑战

前文提到,理想情况下语音合成的训练数据是单人、无噪声、无静音片段的语音,以及与语音对应的文本。这样的要求使得大规模的训练数据需求成为了新的挑战。目前开源的 TTS 数据集多来自播客或有声小说,数据规模也集中在一千小时以下。此外,在语音大模型的 pre-train 过程需要使用多样化的语音数据。如微软的 NaturalSpeech3 在论文中提到,如果只使用来源单一(英文有声书)的语音数据,即使数据达到一定规模,训练出的模型也会因为数据分布单一而无法在真实场景的音色或是其他语言中泛化。

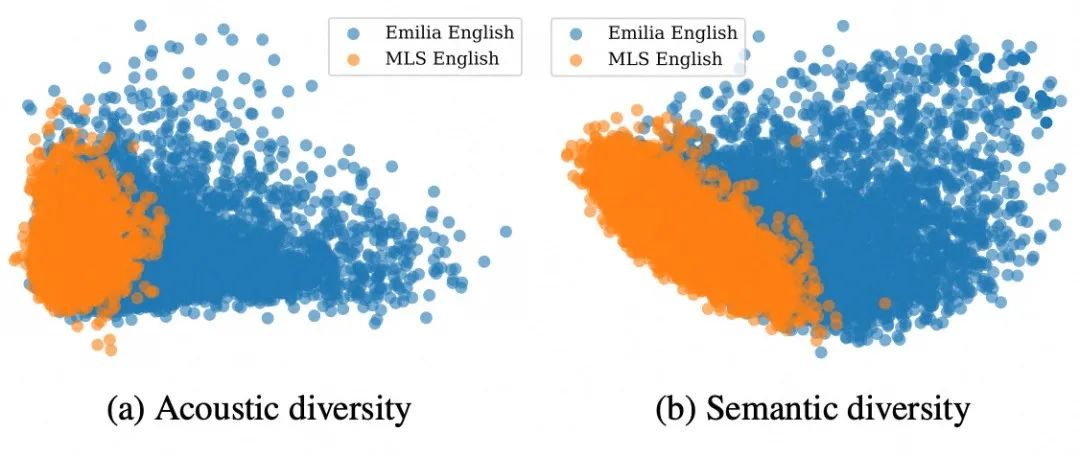

Emilia 和 Wenetspeech4TTS 是目前规模较大的开源中文TTS数据集,其中的数据来源于网络和语音识别数据集。如图8所示, Emilia 数据集在语音的多样性上相较有声书数据集有着显著的提升。

图8:Emilia 与 有声书数据集 MLS 多样性对比

但是,随着规模的增大数据集的质量也出现了一定程度的下降,数据集中出现了噪音、多人对话的音频。这样的训练数据可能会使模型在生成过程中产生偶发的噪音。如在 GPT-4o 语音功能的展示视频中就出现了一些轻微的背景音(也可能是有意为之)。

另一个方面,数据集中的中英混读数据占比较少将导致模型无法展现良好的中英混读效果。如使用 Emilia 训练的 F5-TTS 就并未展现出与中文、英文合成水平相当的中英混读效果。这些问题为语音大模型在实际中的应用带来了一定的挑战。

-

清洗流程

开源语音合成模型已经有了令人惊艳的表现,而在淘宝域的实践中,我们希望继续扩展数据集的分布,使得模型获得以下能力:

-

进一步拟合营销直播、短视频的说话风格

-

适配各类英文商品名称,实现更加自然的中英混读

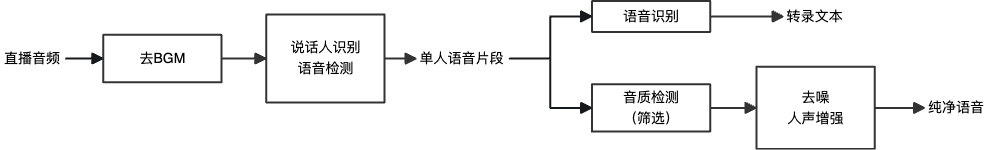

相应的,如何清洗、获取更多淘宝域营销直播、短视频的音频数据,特别是中英混读数据是待解决的问题。针对该问题,我们设计了图9中的自动化清洗链路。

图9:语音数据清洗链路

图9:语音数据清洗链路

清洗效果:

在语音识别阶段,我们使用多个ASR模型进行交叉验证,选取两个识别结果间的编辑距离小于某个阈值的数据。这样的交叉验证进一步保障了转录文本的准确性。

| ASR_1 |

在一聊了很多的公司,有中国的,有国外的啊,有facebook,有腾讯。 |

| ASR_2 |

在一起聊了很多的公司,有中国的,有国外的啊,有facebook,有腾讯、有 |

▐ 音色复刻效果

在完成淘宝域的相关数据收集后,我们对模型进行了相应的优化。这里,我们采用网络上比较有特点的音色进行最终的效果测试。

| 我们来自阿里巴巴淘天集团,国内的亲们,请在购买前检查退货政策。 For foreign consumers, please always check the return policy before purchasing. |

|

▐ 其他探索

音频生成技术除了语音和歌声合成外,还有音效和音乐的合成。随着 OpenAI Sora 的发布视频生成技术越来越成熟,但是目前 AI 生成的视频往往没有声音。为了解决这个问题 Meta 在24年10月发布了视频生成模型 Movie Gen 和视频配音模型 Movie Gen Audio。

以上视频来自 Movie Gen demo 页,画面和音效均为AI生成。可以从视频中看出,音效和 BGM 的加入显著提升了视频的真实度和吸引力。在淘宝域的应用中,我们希望通过与视频匹配的音效和背景音乐的生成提升产品展示的吸引力,让消费者在浏览商品时获得更好的感官体验,增强消费者的购买意愿。下面我们将从 AI视频+AI音效、AI视频+AI BGM、TTS+AI音效三个方面,初步展示我们使用音效和音乐生成技术在淘宝域应用场景中的实验结果。

-

AI 视频 + AI 音效

| AI生成视频(AI配音效前) |

AI生成视频(AI配音效后) |

|

|

-

AI 视频 + AI BGM

| AI生成视频(AI配BGM前) |

AI生成视频(AI配BGM后) |

-

TTS + AI 音效

除了为视频配音外,在有声小说中配上一些与小说描绘的场景相对应的音效可以更加引人入胜。

我们是淘天内容AI团队,负责运用最新的生成式AI能力,挖掘淘宝核心场景的痛点问题,通过内容生成、智能交互等方式,改善用户购物体验、降低平台&商家经营门槛。在过去的几年团队持续以技术驱动产品和商业创新,在给业务创造价值的同时,也在Agent、可控图文、视频生成,多模态统一大模型等最前沿的技术领域也有着广泛布局和深度探索,在NIPS,CVPR,ICLR等顶会发表了数十篇论文,欢迎对团队技术工作感兴趣的同学进行交流或者加入我们。