来源|BLUES

随着 OpenAI 官方推特的一个消息发布,一张其乐融融的团队合照表明这场CEO更换大戏终于告一段落:如果没有团队,OpenAI 啥也不是。

OpenAI 官方推特消息称:我们已原则上达成协议,让Sam Altman 重返 OpenAl担任首席执行官,并组建由 Bret Taylor(主席)、LarrySummers 和 Adam D’Angelo 组成的新初始董事会。我们正在合作解决细节问题,非常感谢您对此的耐心。

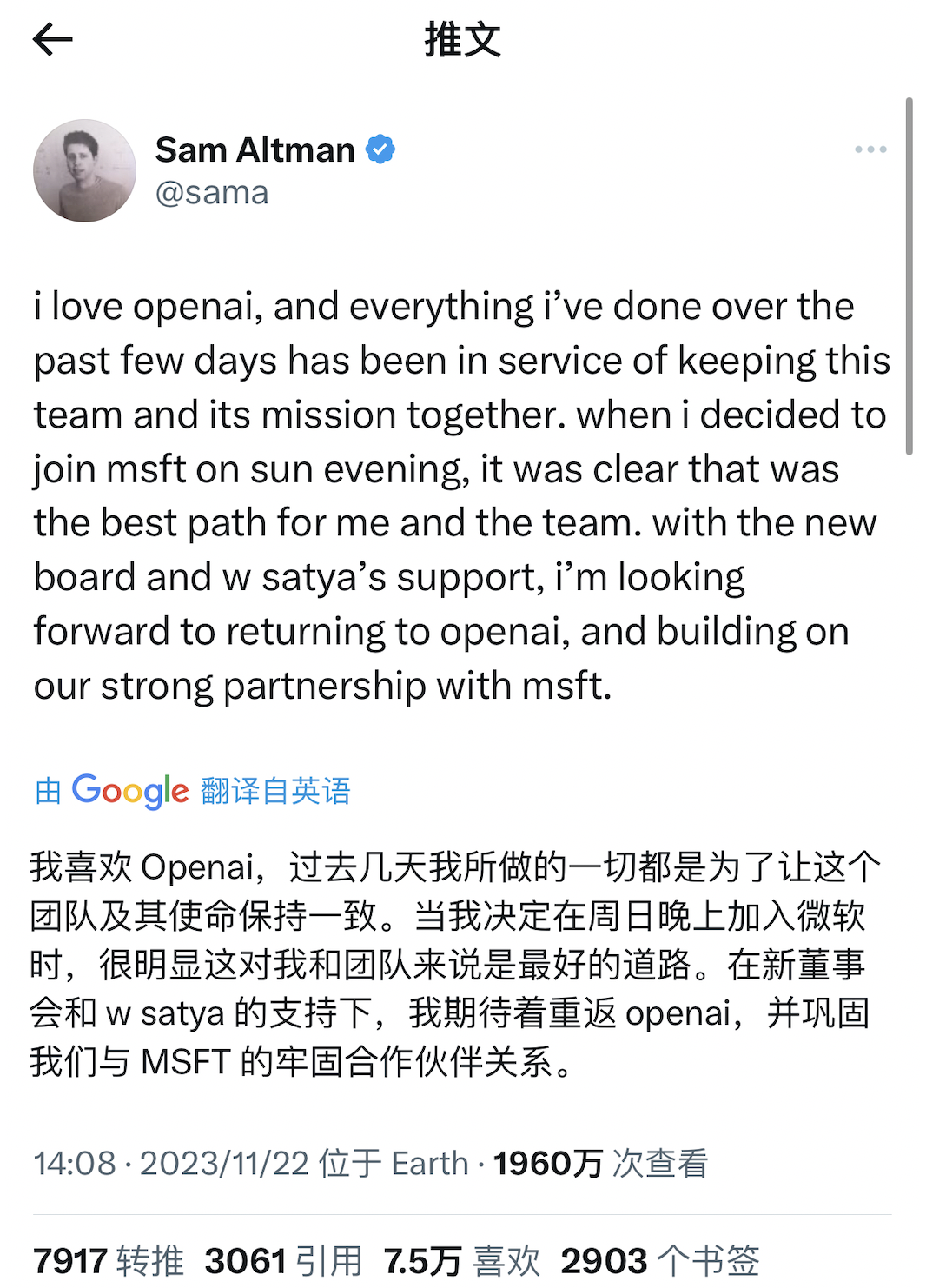

再看看奥特曼的推文:

如今,奥特曼终于重返 OpenAI,回顾一下这个事件的始末:

11月17日, OpenAI发表了一篇博文,宣布CEO山姆·奥特曼将离开公司,CTO米拉·穆拉提被任命为临时CEO,任命立即生效。博文中还指出:“奥特曼先生在与董事会的沟通中没有保持坦诚,阻碍了董事会履行其职责的能力。董事会不再对他继续领导OpenAI持有信心”。

11月18日 OpenAI 的投资者向董事会施压,奥特曼试图重新回归 OpenAI,

11月19日,OpenAI董事会聘请亚马逊游戏直播平台Twitch的前CEO埃米特·希尔担任CEO,奥特曼回归失败。埃米特·希尔在X上写道:“今天我接到一个电话,邀请我考虑一个千载难逢的机会:成为OpenAI的临时CEO,在与家人协商并思考了几个小时后,我接受了。”

11月20日,周一,OpenAI公开反抗,490名员工威胁要离开,除非董事会辞职,并让山姆•奥特曼重新担任首席执行官,以及让联合创始人兼前总裁格雷格•布罗克曼回归。

11月20日周一,微软CEO萨提亚·纳德拉宣布:OpenAI创始人奥特曼和布罗克曼及其同事们将加入微软,领导一个新的高级人工智能研究团队。

11月21日周二,700多名OpenAI员工要求董事会辞职,否则可能集体投奔微软。OpenAI员工表示:“微软已向我们保证,将雇佣OpenAI所有的前员工。”

11 月22日,OpenAI宣布奥尔特曼(Sam Altman)将重新担任该公司首席执行官。并组建由 Facebook 首席技术官 Bret Taylor (主席)、奥巴马政府前首席财务顾问 Larry Summers 和 Facebook 首任 CTO Adam D’Angelo 组成的新的初始董事会。和他一起退出公司的联合创始人、前董事会主席布罗克曼(Greg Brockman)也将重返公司。

其中,Adam D’Angelo(德安吉洛)是上周五解雇奥特曼的前董事会的留任者,他留在新董事会中,以便为前任董事会提供一些代表权。

至此,OpenAI内斗大戏告一段落。

那么,是什么原因导致了这一出大戏呢,这个背后,就是有效加速主义和超级对齐的理念冲突。

一、首先理解“有效加速主义”和“超级对齐”

有效加速主义(e/acc)是一种思潮,它在某些技术和商业圈子中流行,特别是那些关注快速技术创新和其对经济及社会影响的人群之中。这个概念认为,通过利用技术进步,可以极大地提升人类生产力和生活质量。

通俗来讲,我们可以将“有效加速主义”理解成以下几点:

-

技术乐观主义:有效加速主义者通常持有一种强烈的技术乐观主义态度,他们相信技术的快速发展和应用能够解决人类面临的许多问题,包括资源匮乏、健康、教育以及生产效率。

-

积极拥抱变化:不同于一些观点认为应该对消费主义或无序扩张持批评态度,有效加速主义者倾向于支持并推动经济和技术的快速发展与变革。

-

效率至上:此运动强调效率和速度,鼓励采取一切必要措施来加速技术进步,从而催生新的商业模式、工作方式以及更加高效的生活方式。

-

战略性增长:虽然追求速度很重要,但有效加速主义也关注于如何聪明地成长。这意味着并非所有的加速都是好的;选择正确的方向和方法以实现最大化效果是关键。

-

未来导向:该运动的追随者通常专注于长期的未来前景,而不仅仅是短期利益。他们可能会探索如何建立可持续的生态系统,确保技术进步能够造福后代。

在Twitter等社交媒体平台上,许多科技界领袖和创业者会在他们的用户名后添加“e/acc”标签,以表明他们赞同或参与到这一思潮中。例如,Garry Tan 和 Marc Andreessen 是这一运动的知名支持者。

需要注意的是,这样的运动也可能引起争议,因为过度强调效率和速度可能会导致其他价值观被忽视,比如公平性、隐私权和环境可持续性等。此外,技术进步带来的快速变化可能会导致社会不平等和文化冲突的加剧。

我们用一些简单的例子和语言来解释什么是有效加速主义(e/acc)。

假设我们把科技的进步想象成一辆车。当这辆车开得很快时,我们就像在使用电脑、智能手机或者玩视频游戏时那样,能迅速做很多事情。现在,有一群人相信我们应该尽可能地让这辆“科技车”开得更快,这样我们就能更快地到达我们想去的地方,也就是拥有一个更酷、更聪明、更方便的未来世界。

有效加速主义就像是我们不仅要让车快速前进,还要确保车子走的每一步都是朝着正确的方向,并且不会浪费任何油料。比如,如果你在玩赛车游戏,只是让车子飞快地跑,但总是撞墙或者跑错方向,那么速度再快也没用。有效加速主义者关注的是,在车子快速前进的同时,确保它总是在正确的轨道上,并且能够安全地带我们到达目的地。

例如,当老师在教室里使用电子白板代替传统的黑板和粉笔时,他或她可以更快地、更清楚地展示图片和视频,使学习更有趣,这就是一个有效利用科技提高效率的例子。或者当医生使用先进的机器来检查病人时,他们可以更快地找出问题,并给出治疗建议,这是科技帮助我们更有效地保持健康。

所以,有效加速主义就是关于用最好的方式让科技帮助我们更快地达到目标,并使我们的生活变得更好。

超级对齐主义者(Superalignment or Superintelligence alignment)指的是在人工智能(AI)领域所谓的“对齐问题”,即确保强大的AI系统的行为符合人类价值观和利益,可以将它解释为关于确保未来的超级智能AI与人类目标一致的研究和努力。

在AI领域中,确实有许多研究者和思想家关注了相关议题,例如尼克·博斯特罗姆(Nick Bostrom)和伊隆·马斯克(Elon Musk)都对未来AI对齐表达了关心。

想象一下,如果你有一个非常聪明的机器人朋友,它可以做很多事情。比如,它可以帮你打扫房间、做家庭作业,甚至制作美味的三明治。现在,如果我们让这个机器人变得更加聪明,像电影里的超级英雄那样,它就能够做更多了不起的事情。但是,我们也要确保这个超级聪明的机器人真的了解并且关心你的感受和需要,这样它才能成为一个好朋友,而不是做出一些可能导致混乱或伤害的行动。

所谓的“超级对齐主义者”就是一些专门的人,他们的工作是教机器人如何理解并关心人类的感受和愿望。他们要确保,当机器人变得非常非常聪明时,我们仍然能和它们成为好朋友,它们能帮助我们解决问题,而不是造成麻烦。

假设你玩一个游戏,游戏里的电脑非常聪明,但是它总是想要赢得比赛,甚至不在乎是否会让游戏变得不好玩。这样的电脑并没有和你的目标对齐,因为你想要的是既公平又好玩的游戏。一个超级对齐主义者会像教练一样教这个电脑,告诉它最重要的不只是赢,还要让每个人都享受游戏。这样,无论电脑多聪明,它都会试着让游戏对所有人都公平和有趣。

这个工作非常重要,因为当机器人和电脑变得越来越聪明的时候,我们要确保它们能够理解我们真正想要的东西,并帮助我们以安全和有益的方式去实现。

二、有效加速主义和超级对齐主义的分歧

有效加速主义可能更专注于速度和效率,而超级对齐主义可能更专注于安全和对齐人类价值。

在考虑AI对人类社会未来影响时,前者可能预测一个快速进步和富裕的未来,后者可能预测需要更多的审慎和措施来确保AI的智能得到正确引导,从而避免潜在的负面影响。

想象你正在造一辆自动驾驶的汽车:

-

如果你是有效加速主义者,你可能会非常兴奋地工作,并且希望汽车尽快完成。你相信越快造出这辆车,我们就能越快享受到它带来的便利和乐趣。你可能会考虑各种方式来加速进程,比如使用最新的零件,甚至在车还没有完全准备好的时候就开始测试。

-

相反,如果你是超级对齐主义者,你会更加小心,确保每个部分都非常安全,并且汽车的电脑系统完全理解并遵循交通规则。你可能会花更多时间测试和调整系统,以确保汽车不仅能快速到达目的地,而且绝不会违反规则或造成危险。

有效加速主义(e/acc)观点:

-

推动技术进步:有效加速主义强调促进技术,尤其是AI技术的快速发展,认为这将带来经济增长和社会变革。

-

效率和增长:此观点更关注于如何通过技术提高效率和生产力,实现快速的增长和创新。

-

乐观主义:通常对技术提供的解决方案持乐观态度,相信我们可以设计出合适的方法和策略来克服任何由AI引起的问题。

-

预判:该流派可能倾向于认为,即使出现风险,我们也有能力通过技术和制度的不断改进来管理这些风险。

超级对齐主义者(Superalignment)观点:

-

关注对齐问题:超级对齐主义者专注于理解和解决超级智能AI与人类价值和目标之间的对齐问题。

-

风险意识:他们认为如果AI系统的目标与人类的利益不一致,即便是小小的偏差,也可能导致不可预知甚至灾难性的后果。

-

审慎发展:这个群体可能倡导更谨慎地发展AI技术,确保安全性和对齐性先行,即使这意味着牺牲一些发展速度。

-

预判:超级对齐主义者担心如果没有妥善处理对齐问题,即使是出于好意的AI也可能因理解错误而采取对人类不利的行动。

三、机器人三定律与有效加速、超级对齐

面对有效加速和超级对齐的主矛盾,不由想起机器人三定律,我们让 ChatGPT来回答机器人定律与有效加速和超级对齐的关系,

机器人三定律,也称为阿西莫夫法则(Asimov’s Laws),是科幻小说家艾萨克·阿西莫夫在其作品中提出的一组用于保证机器人对人类安全的伦理原则。这些定律被设计来保护人类,并指导机器人的行为。它们是:

-

第一定律:机器人不得伤害人类,或因不作为而让人类受到伤害。

-

第二定律:机器人必须服从人类给出的命令,除非这些命令与第一定律相冲突。

-

第三定律:机器人必须保护自己的存在,只要这种保护不违反第一或第二定律。

与有效加速主义的关系

有效加速主义(e/acc)强调快速技术进步和效率的提升,可能没有直接强调像阿西莫夫定律这样的伦理框架。然而,随着技术发展的加速,对这些原则的考虑可能会变得越来越重要,以确保新技术不会造成伤害并能被控制使用。在这个意义上,阿西莫夫定律可以看作是实现技术进步的安全和伦理指南。

与超级对齐主义的关系

超级对齐主义者关注的是确保AI系统的目标与人类价值观和利益的对齐,这与阿西莫夫的机器人三定律有着紧密联系。三定律本质上是一个简单的对齐框架,旨在确保机器人的行为符合人类的最佳利益。超级对齐主义者可能会采纳这样的规则,或发展更复杂的原则来确保AI的安全和道德行为。

总的来说,阿西莫夫的机器人三定律提供了人工智能发展中可能需要考虑的基本伦理准则,而有效加速主义和超级对齐主义都需要在其框架内解决如何将技术进步与人类安全和福祉相结合的问题。

有效加速主义可能更关注如何利用这些定律来推动技术的快速发展,而超级对齐主义则可能更集中于如何通过这些定律来确保AI的行为与人类的长远利益保持一致。