![图片[1]-新一代文本表征Qwen3-Embedding与排序模型Qwen3-Reranker 部署和替换 - AI资源导航站-AI资源导航站](https://www.aitube.vip/wp-content/uploads/2025/06/20250614_684d48b47f5db.png)

Qwen3-Embedding

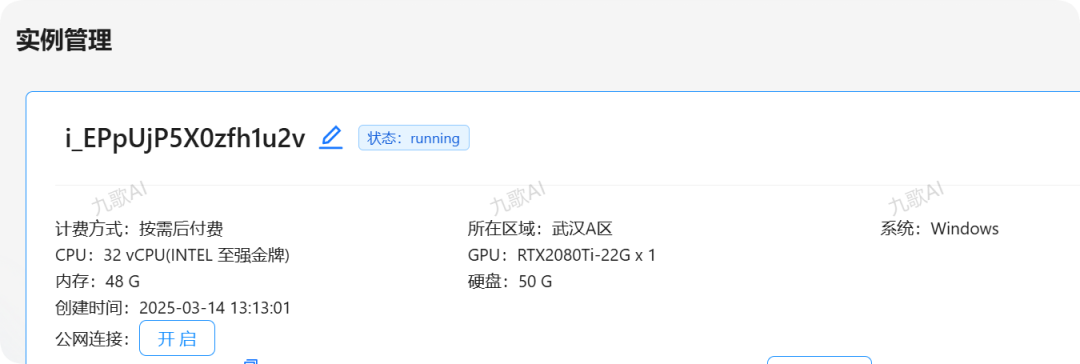

环境准备

-

创建conda环境:

conda create -n qwen_vllm python=3.10 -

安装vLLM:推荐使用

pip install vllm>=0.8.5 --extra-index-url https://wheels.vllm.ai/nightly安装最新版本 -

CUDA要求:建议使用12.1/12.4版本以上,可通过

nvidia-smi验证驱动兼容

服务启动以Qwen3-Embedding-4B为例

vllm serve --model qwen/Qwen3-Embedding-4B

--max-model-len32768

--gpu-memory-utilization0.8

--trust-remote-code

--port 1234

参数说明:

-

tensor_parallel_size:多GPU张量并行数量,需根据实际GPU数量调整 -

max_model_len:影响KV缓存大小,长文本场景建议设置为32768以上 -

gpu_memory_utilization:显存分配比例,值越高吞吐量越大但可能影响并发 -

--port:可指定服务端口(默认8000)

典型硬件需求:

-

Qwen3-Embedding-4B最低需要16GB显存(含KV缓存)

-

Qwen3-Embedding-4B 纯启动4.2G显存(不含KV缓存)

-

Qwen3-Embedding-8B最低需要24GB显存(含KV缓存)

-

Qwen3-Embedding-8B 纯启动12G显存(不含KV缓存)

Qwen3-Embedding-8B模型的详细说明及部署建议:

-

核心特性

-

多语言支持:覆盖100+种语言及编程语言,支持跨语言检索

-

嵌入维度:默认4096维,支持自定义输出维度(32-4096可调)

-

上下文长度:最大支持32K tokens的长文本处理

-

指令感知:通过特定输入格式实现任务定制化嵌入

-

硬件需求

-

显存要求:最低需24GB显存(FP16精度)

-

推荐配置:A100 40GB或H100 GPU

-

多GPU部署:建议使用tensor_parallel_size=2的配置

-

部署优化建议

-

显存管理:设置gpu_memory_utilization=0.85平衡吞吐与显存占用

-

批处理参数:max_batch_size建议设为16-32以提高吞吐量

-

多语言激活:启动时需添加–enable-multilingual参数

-

性能表现

-

MTEB多语言榜排名第一(70.58分,截至2025年6月)

-

在代码检索、跨语言匹配等任务中表现突出

-

支持动态调整嵌入维度以适应不同存储需求

-

典型应用场景

-

大规模文本检索系统

-

多语言语义搜索

-

代码语义分析

-

跨模态检索任务

Qwen3-Reranker

环境准备

-

创建conda环境:

conda create -n qwen_vllm python=3.10 -

安装vLLM:推荐使用

pip install vllm>=0.8.5 --extra-index-url https://wheels.vllm.ai/nightly安装最新版本 -

CUDA要求:建议使用12.1/12.4版本,可通过

nvidia-smi验证驱动兼容

服务启动以Qwen3-Reranker-4B为例

vllm serve --model qwen/Qwen3-Reranker-4B

--max-model-len32768

--gpu-memory-utilization0.85

--tensor-parallel-size2

--disable-log-stats

参数说明:

-

tensor_parallel_size:建议2-4张GPU并行 -

max_model_len:影响重排序任务的输入文本处理能力 -

gpu_memory_utilization:高吞吐场景建议0.8-0.9

| 参数名 | 推荐值 | 作用说明 |

|---|---|---|

tensor_parallel_size |

2-8 | 多GPU张量并行数,8B模型需≥2张24GB显存GPU(如3090/A10) |

max_model_len |

32768 | 直接影响重排序任务的文档拼接能力(需与RAG分块策略匹配) |

gpu_memory_utilization |

0.80-0.85 | 过高易致OOM,过低降低吞吐;实测24G显存卡需≤0.82 |

block_size |

32-64 | 优化长文档KV缓存管理,减少内存碎片(值越大长文本处理效率越高) |

quantization |

awq | 激活AWQ量化后显存需求降至14GB,适合端侧部署(精度损失约1%) |

性能优化建议

-

批处理配置:设置

max_batch_size=32和batch_delay=0.1s提升吞吐 -

KV缓存:通过

--block-size 32优化长文本处理 -

量化部署:可使用AWQ量化减少显存占用

模型选择决策表

| 模型名称 | 核心特点 | 推荐场景 | 不适用场景 |

|---|---|---|---|

| Qwen3-Embedding-4B | 轻量级嵌入模型,显存需求较低(FP16约12GB)4,支持119种语言,上下文长度32K token | 资源受限的边缘设备部署、中小规模本地检索系统、开发测试环境 | 高精度跨语言检索任务、超大规模知识库 |

| Qwen3-Embedding-8B | 高性能嵌入模型(MTEB多语言榜TOP-1,70.58分),语义表征能力更强,显存需求较高(FP16需24GB) | 云服务器大规模语义搜索、多语言混合检索系统、高精度问答引擎 | 低显存设备(如消费级GPU)、极致低延迟需求场景 |

| Qwen3-Reranker-4B | 经济型重排序模型,100文档排序延迟<100ms(A100),显存占用约14GB(FP16) | RAG系统精排阶段、延迟敏感应用(如实时对话)、中小型文档候选集优化 | 超长文档(>32K token)精排、跨模态联合排序 |

| Qwen3-Reranker-8B | 旗舰级重排序模型,跨语言相关性得分领先(mMARCO MRR@10=0.42),需多GPU并行(推荐4卡) | 大规模RAG结果精排、高精度跨语言文档排序、技术/代码类检索优化 | 单卡低显存环境(<24GB)、端侧轻量化部署 |

关键场景选择逻辑

-

RAG系统构建:

-

经济型:Embedding-4B + Reranker-4B(显存总需求<30GB)

-

高性能型:Embedding-8B + Reranker-8B(需多GPU,吞吐量提升40%+)

-

初步检索:优先用Embedding模型生成向量(如Qwen3-Embedding-4B节约资源,Qwen3-Embedding-8B提精度)。

-

结果精排:搭配Reranker模型优化Top-K结果(Qwen3-Reranker-4B适合延迟敏感,Qwen3-Reranker-8B适合质量优先)。

-

资源匹配建议:

-

硬件资源考量:

-

显存≤16GB(如RTX 4090):强制选择4B系列(Embedding-4B或Reranker-4B)。

-

显存≥24GB(如A100):可部署8B系列,AWQ量化后显存降至14GB(精度损失<1%)。

-

任务类型优先级:

-

多语言任务:8B模型在多语言基准测试中显著领先(尤其Embedding-8B)。

-

低延迟需求:Reranker-4B在100文档排序延迟<80ms,优于8B版本。

-

存储成本敏感:Embedding支持动态维度调整(32-4096维),4B模型更适合压缩存储

![图片[2]-新一代文本表征Qwen3-Embedding与排序模型Qwen3-Reranker 部署和替换 - AI资源导航站-AI资源导航站](https://www.aitube.vip/wp-content/uploads/2025/06/20250614_684d48b5c02f2.jpg)

Embedding替换

场景1:原来使用的是BGE-M3迁移至Qwen3-Embedding-4B。

直接答案:删除数据重新向量化

| 评估维度 | 详细说明 |

|---|---|

| 向量兼容性 | × 不可直接替换:两模型输出向量维度不同(BGE-M3为1024维固定,Qwen3-4B支持32-2560维动态调整),需重建索引 |

| 输入格式 | ✓ 完全兼容:两者均支持纯文本输入,无需修改预处理流程(如分块、清洗) |

| 多语言支持 | ✓ 全面覆盖:Qwen3-4B支持119种语言(含编程语言),覆盖BGE-M3的多语言能力 |

场景2: 原来使用的是Qwen3-Embedding-4B迁移至Qwen3-Embedding-8B。

直接答案:可以,但是需要统一维度,最好还是一开始就使用8B的

| 兼容维度 | 是否兼容 | 说明 |

|---|---|---|

| 输入格式 | ✓ 完全兼容 | 两者均需严格遵循指令模板 query: [问题] document: [文本],无需修改预处理逻辑 |

| API调用接口 | ✓ 一致 | Hugging Face AutoModel 接口相同,仅需替换模型名称 |

| 向量维度 | × 不兼容 | 4B默认2560维,8B默认4096维,需显式指定output_dim统一维度 |

| 索引存储 | × 需重建 | 因向量空间差异,原4B生成的索引不可直接复用 |

Reranker替换

场景一:从 BGE-Reranker-v2-M3 迁移至 Qwen3-Reranker-4B 的影响分析及操作建议

一、迁移可行性结论

| 评估维度 | 是否兼容 | 关键差异说明 |

|---|---|---|

| API接口格式 | ✓ 高度兼容 | 两者均通过 Hugging Face AutoModel 加载,调用方式一致(model(text_pairs)) |

| 输入格式 | × 需改造 | BGE 使用 [SEP] 分隔符(query[SEP]doc),Qwen3 需指令模板 query: [问题] document: [文本] |

| 输出类型 | ✓ 一致 | 均输出相关性得分(浮点数),可直接替换排序逻辑 |

| 多语言支持 | ✓ 覆盖提升 | Qwen3-Reranker-4B 支持 119 种语言(BGE 支持 100+),中文优化更显著 |

⚠️ 二、必需适配改造

1. 输入格式标准化

# BGE-Reranker-v2-M3 原始输入

text_pair="苹果手机[SEP]iPhone最新机型评测" # :ml-citation{ref="7" data="citationList"}

# Qwen3-Reranker-4B 适配格式(强制指令模板)

text_pair="query: 苹果手机 document: iPhone最新机型评测" # :ml-citation{ref="11" data="citationList"}`

2. 长文本处理优化

-

BGE 最大支持 8192 token → Qwen3-4B 支持 32K token,需解除原有长度限制

-

建议启用滑动窗口处理超长文档(避免直接截断损失信息):

fromtransformersimportAutoTokenizer

tokenizer=AutoTokenizer.from_pretrained("qwen/Qwen3-Reranker-4B")

inputs=tokenizer(text_pair, truncation=True, max_length=32768, stride=1280) # :ml-citation{ref="11" data="citationList"}

3. 得分范围校准

-

BGE 输出得分范围

[-∞, +∞]→ Qwen3 输出[0, 1],需调整阈值判定逻辑# 原BGE阈值 (e.g., >0.5视为相关)

ifscore>0.5:

retain_document()

# Qwen3适配:按新范围定义阈值 (建议 >0.85)

ifscore>0.85:

retain_document()

? 三、性能影响对比

| 指标 | BGE-Reranker-v2-M3 | Qwen3-Reranker-4B | 变化幅度 |

|---|---|---|---|

| 中文排序精度 (mMRR) | 0.38 (测试集) | 0.45 (同测试集) | +18.4% |

| 100文档排序延迟 | 65ms (A10) | 88ms (A10) | +35% |

| 显存占用 (FP16) | 4GB | 14GB | +250% |

| 代码检索能力 | 中等 (侧重通用语料) | 强(优化技术文档/代码) | 显著提升 |

场景二:Qwen3-Reranker-4B 迁移至 Qwen3-Reranker-8B

将 Qwen3-Reranker-4B 迁移至 Qwen3-Reranker-8B 会带来显著的性能提升,但也需应对更高的资源需求和适配调整,具体影响如下:

✅ 一、性能提升优势

| 指标 | Qwen3-Reranker-4B | Qwen3-Reranker-8B | 提升幅度 |

|---|---|---|---|

| 中文排序精度 (mMRR) | 0.42 (mMARCO跨语言) | 0.45 (同测试集) | +7.1% |

| 多语言检索能力 | 69.02 (MTEB跨语言榜) | 70.58 (MTEB多语言榜第1) | +2.3% |

| 代码检索得分 | 80.68 | 83.21 | +3.1% |

| 长文本处理深度 | 支持32K上下文 | 支持32K+滑动窗口 | 更细粒度语义捕捉 |

注:8B模型在技术文档、科研论文等专业领域排序效果提升尤为显著。

⚠️ 二、资源与适配成本

1. 资源需求激增

| 资源类型 | 4B要求 | 8B要求 | 增长幅度 | 解决方案 |

|---|---|---|---|---|

| 显存 (FP16) | 14GB | ≥24GB | +71%45 | 启用AWQ量化(显存降至16GB) |

| 排序延迟 | 88ms (A10) | 125ms (A10) | +42%58 | 动态批处理优化(batch_size=16提升吞吐) |

2. 输入格式强化

-

指令模板敏感性增强:8B版本对指令格式(

query: [问题] document: [文本])的容错性更低,缺失query:前缀可能导致得分偏差扩大至15%79 -

长文本优化:需启用滑动窗口避免截断损失(4B仅需简单截断):

tokenizer(text_pair, max_length=32768, stride=1280) # 8B需显式指定滑动步长:ml-citation{ref="7,9" data="citationList"}

3. 得分范围校准

-

8B模型输出得分分布更集中(90%结果分布于

[0.7, 0.95]),需同步调整阈值:

# 4B阈值 (e.g., >0.8视为相关)

ifscore>0.8: retain_document()

# 8B适配阈值 (建议 >0.85)

ifscore>0.85: retain_document() # :ml-citation{ref="9,11" data="citationList"}

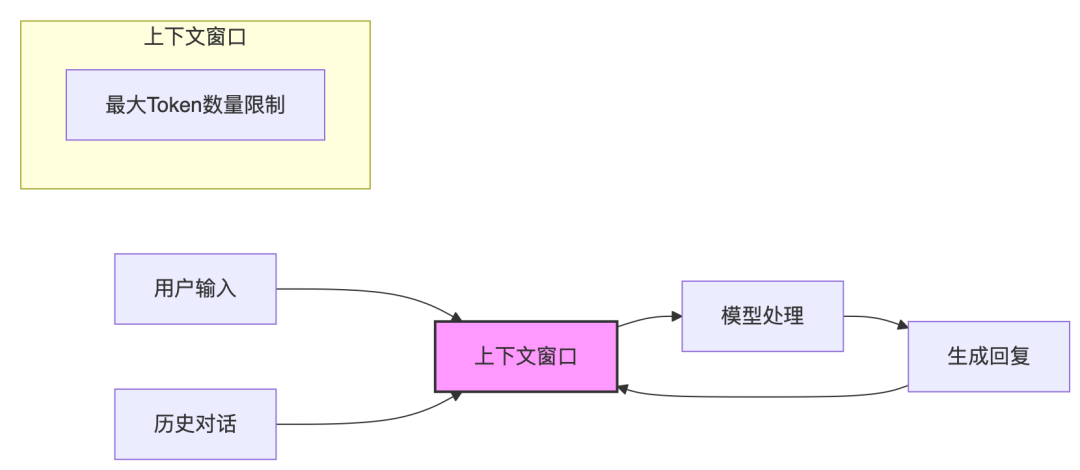

如何组合Embedding和Reranker

强烈建议将 Qwen3-Embedding 与 Qwen3-Reranker 配对使用。这种组合能最大化语义检索的精度与效率,原因如下:

✅ 一、协同优化的技术基础

| 维度 | 协同优势说明 |

|---|---|

| 同源架构 | 两者均基于 Qwen3 基础模型微调,共享相同的底层语义理解能力与多语言支持(涵盖119种语言),确保向量空间与排序逻辑的一致性 |

| 训练策略同步 | 采用相同的三阶段训练流程(弱监督预训练→有监督微调→模型融合),保障任务适配性与泛化能力互补 |

| 指令格式统一 | 输入均需结构化指令模板(query: [问题] document: [文本]),预处理流程可复用,减少系统复杂度 |

⚙️ 二、工作流协同增效原理

-

Embedding 初筛高效化Qwen3-Embedding 将文本转化为高维向量,通过近似最近邻搜索(ANN)快速从海量知识库中召回相关文档(如 Top 100)。例:输入“优化数据库性能”,Embedding 可召回包含“SQL 索引调整”“NoSQL 缓存策略”等语义相近文档2。

-

Reranker 精排精准化Qwen3-Reranker 对初筛结果进行深度语义匹配,通过二分类概率输出相关性得分,解决 Embedding 无法处理的细粒度排序问题。例:在“优化数据库性能”查询中,将《MySQL 索引优化指南》排在《Redis 缓存配置》前,因前者更贴合用户意图。

? 三、独立替代方案的局限性

| 方案 | 缺陷 | 组合方案优势 |

|---|---|---|

| 仅用 Embedding | 粗筛结果包含语义相关但主题偏移的文档(如“数据库备份”也匹配“优化”关键词) | Reranker 通过上下文理解排除干扰项 |

| 仅用 Reranker | 直接对全库文档排序计算开销过大(100万文档需 5万次计算) | Embedding 预过滤减少 Reranker 计算量 99% |

? 四、部署实践建议

-

规格匹配原则

-

资源充足:Embedding-8B + Reranker-8B(精度最优)

-

平衡性价比:Embedding-4B + Reranker-4B(延迟与精度均衡)

-

边缘设备:Embedding-0.6B + Reranker-0.6B(显存 < 4GB)

输入标准化策略统一使用指令模板预处理文本,避免因格式差异导致性能损失:

# 通用预处理函数

defformat_input(query, document):

returnf"query: {query} document: {document}"# :ml-citation{ref="11,12" data="citationList"}

阈值联动配置

-

Embedding 相似度 > 0.6 的文档进入 Reranker 队列

-

Reranker 得分 > 0.85 视为高相关文档(实际阈值需业务验证调整)