导读 随着人工智能技术的不断进步,语音合成技术在游戏和娱乐领域扮演着越来越重要的角色。本次分享题目为“腾讯游戏知几语音合成大模型推理加速实践”,主要介绍腾讯在语音合成领域的产品展示、模型结构分析、推理加速方案以及未来展望。

1. 背景-产品展示

2. 模型结构选型与分

3. 模型推理加速方案

4. 未来展望

出品社区|DataFun

01

-

声音复刻:仅需 10 秒音频即可完成声音复刻。 -

实时性能:通过加速优化,其实时率约为 0.085。

![图片[1]-腾讯语音合成技术:模型优化与推理加速实践 - AI资源导航站-AI资源导航站](https://www.aitube.vip/wp-content/uploads/2025/02/20250213_67adc231019e4.png)

-

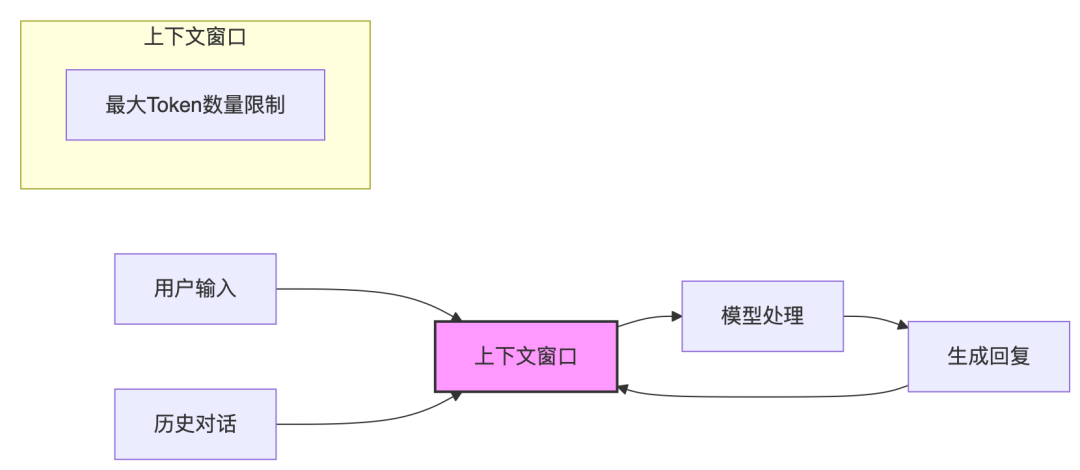

文本问答:

输入方式:玩家通过文本输入问题或指令。

输出方式:系统利用人工智能技术处理后,返回相应的文本回答。

-

语音交互:

输入方式:玩家通过语音与 AI 语音助手进行交流。

输出方式:系统经过 AI 处理后,以语音形式回应玩家。

-

多模态 NPC(非玩家角色):

输入方式:玩家可以通过文本或语音与 NPC 进行互动。

输出方式:系统经过 AI 处理后,NPC 可以返回文本、语音、肢体动作、面部表情和口型动作等多种形式的数据,提供更加丰富和自然的交互体验。

模型结构选型与分析

-

输入文本。 -

通过声学模型生成梅尔谱图(Mel-spectrogram)。 -

通过声码器(Vocoder)将梅尔谱图转换为语音。

1. 语音合成大模型结构

-

输入文本: 输入一段文本。 -

Tokenization: 对输入文本和需要克隆的语音分别进行 Token 化处理,生成文本 Token 和语音 Token。 -

连接与编码: 将文本 Token 和语音 Token 连接在一起。 通过旋转位置编码(Rotary Position Encoding)对文本和音频分别进行编码,生成最终的嵌入向量(Embedding)。 -

自回归模型(AR Model): 将嵌入向量输入到 AR 模型中,逐步生成第一层音素 Token。 AR 模型的结构与传统的自然语言处理大模型(如 GPT 类模型)类似,采用 Transformer 架构。 -

非自回归模型(NAR Model): 将 AR 模型生成的音素 Token 输入到 NAR 模型中,生成所有语音 Token。 Codec Decoder: 最后,通过 Codec Decoder 将语音 Token 转换为最终的语音输出。

![图片[2]-腾讯语音合成技术:模型优化与推理加速实践 - AI资源导航站-AI资源导航站](https://www.aitube.vip/wp-content/uploads/2025/02/20250213_67adc2324390e.png)

2. 面临的挑战

模型推理加速方案

1. KV Cache

-

Attention 输出的第 n 行只与第 n 个 Query (Q)相关:这意味着每个 Token 的输出只依赖于当前 Token 的 Query 和之前所有 Token 的 Key (K) 和 Value (V)。

-

第 1 到第 n 个 Token 的 Attention 计算包含第 1 到第 n-1 个 Token 的Attention 计算:这意味着每次计算新的 Token 时,可以复用之前 Token 的 K 和 V 值,而不需要重新计算。

-

每次 Attention 的计算都使用前面的 K 和 V:每次生成新的 Token 时,只需计算新 Token 的 K 和 V 值,并结合之前缓存的 K 和 V 值进行计算。

2. GQA

4. 连续性批处理

-

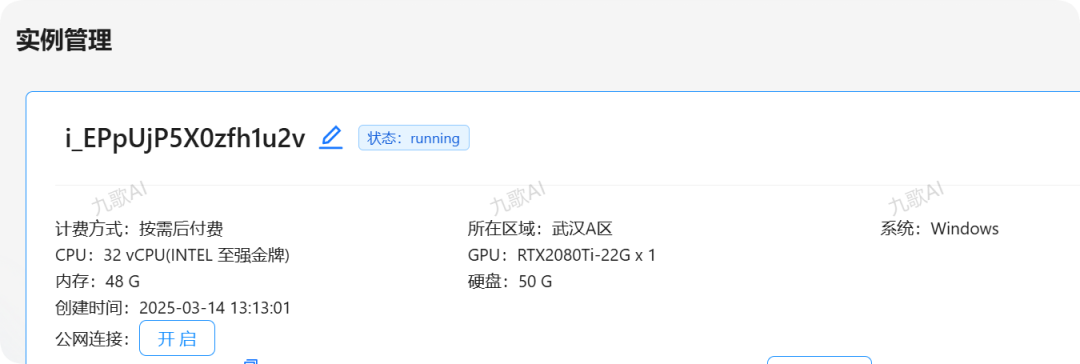

训练时采用的方案一

-

推理时采用的方案二

![图片[11]-腾讯语音合成技术:模型优化与推理加速实践 - AI资源导航站-AI资源导航站](https://www.aitube.vip/wp-content/uploads/2025/02/20250213_67adc238d3530.png)

5. 推理加速效果

未来展望

-

引入投机采样技术:我们将探索将投机采样方法应用于大型语音合成模型的可能性。通过这种技术,可以在生成过程中提前预测并选择最有可能的输出路径,从而加速音频合成过程,并可能提高最终合成音频的质量。

-

改造非自回归(NAR)模型为流式输出架构:为了实现更低延迟和更高效的音频生成,我们打算对现有的 NAR 模型进行调整,使其支持流式输出模式。这样,模型能够一边生成音频数据一边实时输出,极大地提升了用户体验,特别是在需要即时响应的应用场景中。

-

研究更多非 Transformer 网络架构:虽然 Transformer 架构在许多方面表现优异,但我们认为探索其他类型的神经网络结构同样重要。这包括但不限于卷积神经网络(CNN)、循环神经网络(RNN)及其变体等。我们的目标是发现那些在特定任务上具有优势且能提供更高效率或更好性能的新架构。