训练成本的指数级增长

如何解决这个问题?

一、MoE(Mixture-of-Experts)架构的基本思路

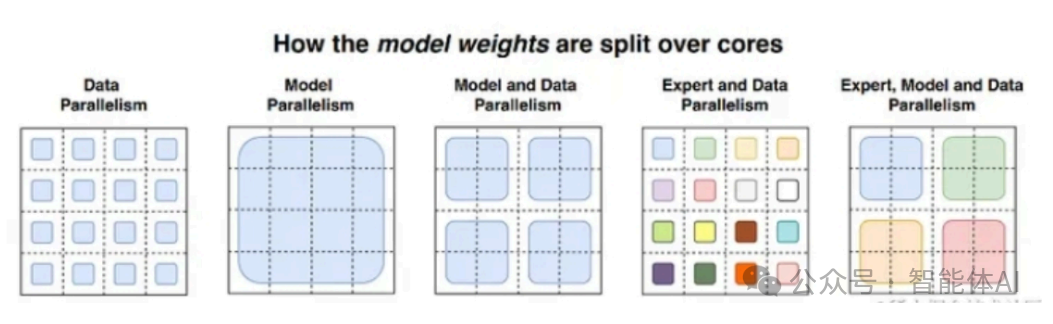

1. MoE的工作原理

具体过程如下:

-

输入样本进入门控网络:门控网络(Gate Network)会根据样本的特征,计算出每个专家的激活权重。

-

选取Top-K个专家:通过Softmax计算,门控网络会为每个样本选择Top-K个最相关的专家(通常是1或2个)。

-

专家计算并输出结果:选中的专家会对输入样本进行计算,最终将各专家输出的结果加权合并,得出最终的预测结果。

这种机制确保了只有部分专家会被激活,从而减少了计算资源的浪费。

2. 比较传统模型和MoE模型

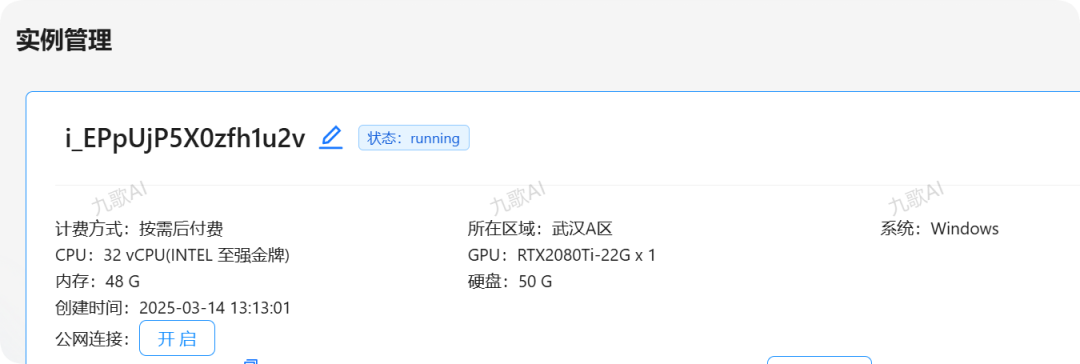

二、MoE(Mixture-of-Experts)分布式并行策略

1. MoE + 数据并行

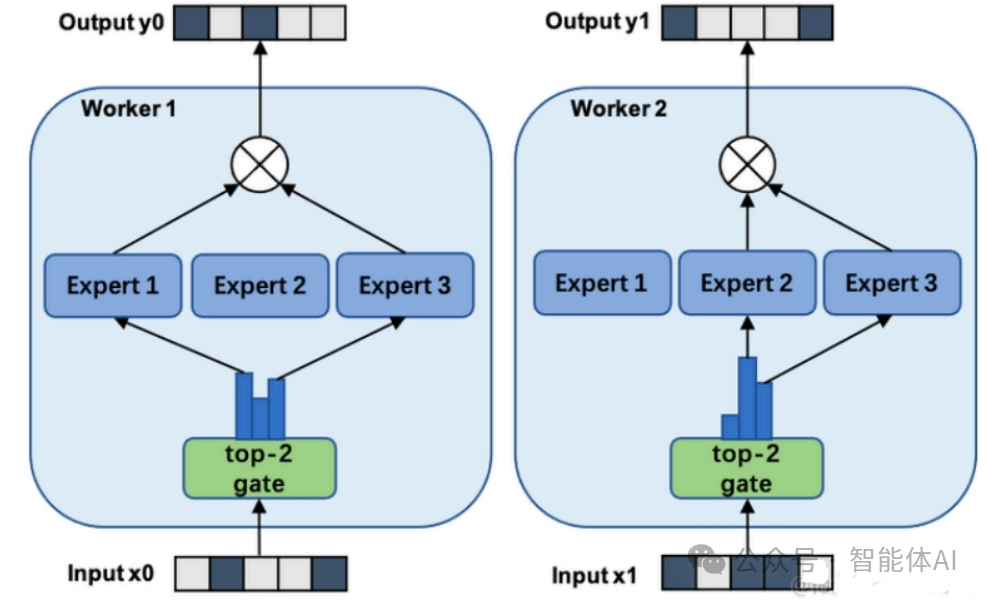

2. MoE + 模型并行

三、MoE大模型的优势

1. 训练速度更快,效果更好

2. 相同参数,推理成本低

3. 优越的扩展性

4. 多任务学习能力

四、MoE大模型的挑战

1. 训练稳定性问题

2. 高通信成本

3. 模型复杂性

4. 过拟合问题

五、MoE如何实现更大模型参数、更低训练成本?

1. 稀疏路由的优势

2. 混合精度训练

六、MoE如何解决训练稳定性和过拟合问题?

1. 负载均衡损失

2. Dropout与学习率调整

七、MoE在大语言模型中的应用场景

-

解决多模态问题

在多模态学习中,MoE能够将不同模态的数据(如文本、图像、语音)分别分配给各个专家进行处理,从而提升模型的处理能力。 -

垂直领域应用

对于一些特定领域任务,MoE通过让不同领域的专家各自承担不同任务,能够提高模型的针对性和效果。 -

提高模型规模与效率

MoE的稀疏计算技术使得训练更大规模的模型成为可能,同时也能够提高训练效率和推理速度。 -

自然语言处理

MoE技术已经在自然语言处理(NLP)领域取得了显著的成果,如在机器翻译中引入MoE后,显著提升了翻译效果。

八、总结

参考资料:图片来源论文和网络

© 版权声明

文章版权归作者所有,未经允许请勿转载。

THE END